ແນະນໍາໂລກຂອງຂໍ້ມູນໃຫຍ່

THE ຂໍ້ມູນໃຫຍ່ ເປັນຕົວແທນຂອງຂະແຫນງການຂະຫຍາຍຕົວທີ່ກໍາລັງຫັນປ່ຽນວິທີການທຸລະກິດແລະອົງການຈັດຕັ້ງວິເຄາະແລະນໍາໃຊ້ຂໍ້ມູນ. ໃນໂລກດິຈິຕອນທີ່ນັບມື້ນັບເພີ່ມຂຶ້ນ, ຂໍ້ມູນແມ່ນໄດ້ຖືກສ້າງຂຶ້ນດ້ວຍຄວາມໄວ breakneck ແລະໃນຫຼາຍຮູບແບບ.

ຍຸກຂອງ Big Data ບໍ່ແມ່ນພຽງແຕ່ buzzword; ມັນເປັນຄວາມເປັນຈິງທີ່ກໍາລັງສ້າງອຸດສາຫະກໍາທັງຫມົດແລະກໍານົດຂອບເຂດຂອງວິທະຍາສາດ, AI ແລະເຕັກໂນໂລຢີໃຫມ່.

ຂໍ້ມູນໃຫຍ່ແມ່ນຫຍັງ?

THE ຂໍ້ມູນໃຫຍ່ ຫມາຍເຖິງຊຸດຂໍ້ມູນທີ່ມີຂະຫນາດໃຫຍ່ຫຼືສະລັບສັບຊ້ອນທີ່ເກີນຄວາມສາມາດຂອງຊອບແວການຄຸ້ມຄອງຖານຂໍ້ມູນແລະເຄື່ອງມືແບບດັ້ງເດີມ. ຂໍ້ມູນນີ້ແມ່ນມາຈາກແຫຼ່ງທີ່ຫຼາກຫຼາຍ ແລະຫຼາກຫຼາຍເຊັ່ນ: ເຄືອຂ່າຍສັງຄົມ, ການເຮັດທຸລະກໍາອອນໄລນ໌, ເຊັນເຊີ IoT (Internet of Things), ຫຼືແມ້ກະທັ້ງການບັນທຶກມັນຕິມີເດຍ.

3Vs ຂອງຂໍ້ມູນໃຫຍ່

ແນວຄວາມຄິດຂອງຂໍ້ມູນໃຫຍ່ມັກຈະຖືກສະຫຼຸບໂດຍສາມ Vs: ປະລິມານ, ຄວາມໄວ ແລະ ຫຼາກຫຼາຍຊະນິດ. ປະລິມານໝາຍເຖິງຈຳນວນຂໍ້ມູນທີ່ສ້າງຂຶ້ນ, ຄວາມໄວໝາຍເຖິງຄວາມໄວທີ່ຜະລິດ ແລະປຸງແຕ່ງ, ແລະຄວາມຫຼາກຫຼາຍໝາຍເຖິງປະເພດຂໍ້ມູນທີ່ແຕກຕ່າງກັນ, ມີໂຄງສ້າງ ແລະບໍ່ມີໂຄງສ້າງ, ທີ່ມີຢູ່. ເພື່ອເຫຼົ່ານີ້ສາມ Vs ບາງຄັ້ງກໍ່ຖືກເພີ່ມ ຄວາມຖືກຕ້ອງ, ສໍາລັບຄວາມຖືກຕ້ອງຂອງຂໍ້ມູນ, ແລະ ມູນຄ່າ, ເປັນຕົວແທນຂອງຄວາມສໍາຄັນແລະເປັນປະໂຫຍດຂອງຂໍ້ມູນນີ້.

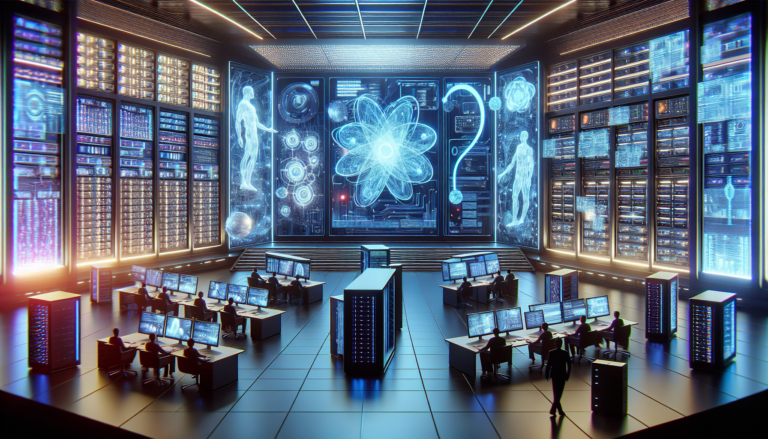

ເຕັກໂນໂລຊີຂໍ້ມູນໃຫຍ່ ແລະເຄື່ອງມື

ເພື່ອຈັດການ ແລະປະມວນຜົນຂໍ້ມູນໃຫຍ່, ເຕັກໂນໂລຊີ ແລະ ເຄື່ອງມື ສະເພາະແມ່ນມີຄວາມຈໍາເປັນ. ເວທີເຊັ່ນ Apache Hadoop ແລະ ປະກາຍໄຟ ເປີດໃຊ້ການແຈກຢາຍແລະການປະມວນຜົນຂອງຊຸດຂໍ້ມູນຂະຫນາດໃຫຍ່. ເຄື່ອງມືອື່ນໆເຊັ່ນ NoSQL, ຖານຂໍ້ມູນທີ່ບໍ່ກ່ຽວຂ້ອງ, ຍັງໄດ້ຮັບຄວາມນິຍົມສໍາລັບຄວາມຍືດຫຍຸ່ນແລະຄວາມສາມາດໃນການຈັດການຂໍ້ມູນຈໍານວນຫລາຍທີ່ຫຼາກຫຼາຍ.

ການວິເຄາະຂໍ້ມູນໃຫຍ່

ການລວບລວມຂໍ້ມູນແມ່ນພຽງແຕ່ຂັ້ນຕອນທໍາອິດ; ການວິເຄາະຂໍ້ມູນໃຫຍ່ແມ່ນສິ່ງທີ່ປ່ຽນຂໍ້ມູນດິບນີ້ເປັນຂໍ້ມູນທີ່ມີຄຸນຄ່າສໍາລັບການຕັດສິນໃຈ. ນີ້ກ່ຽວຂ້ອງກັບການນໍາໃຊ້ເຕັກນິກການກ້າວຫນ້າທາງດ້ານເຊັ່ນ: ການຮຽນຮູ້ເຄື່ອງຈັກ, ການວິເຄາະຄາດຄະເນຫຼືແມ້ກະທັ້ງການປຸງແຕ່ງພາສາທໍາມະຊາດເພື່ອຄົ້ນພົບຮູບແບບ, ແນວໂນ້ມແລະໄດ້ຮັບຄວາມເຂົ້າໃຈ.

ຜົນກະທົບຂອງຂໍ້ມູນໃຫຍ່ໃນໂລກມື້ນີ້

Big Data ມີຜົນກະທົບຢ່າງຫຼວງຫຼາຍໃນດ້ານຕ່າງໆເຊັ່ນ: ການຕະຫຼາດ, ສຸຂະພາບ, ການເງິນ, ຫຼືສະພາບແວດລ້ອມ. ຄວາມສາມາດໃນການວິເຄາະຂໍ້ມູນຈໍານວນຫຼວງຫຼາຍເຮັດໃຫ້ທຸລະກິດສາມາດເຂົ້າໃຈລູກຄ້າຂອງພວກເຂົາໄດ້ດີຂຶ້ນ, ເພີ່ມປະສິດທິພາບການປະຕິບັດງານຂອງພວກເຂົາແລະປະດິດສ້າງຜະລິດຕະພັນແລະການບໍລິການຂອງພວກເຂົາ.

ສິ່ງທ້າທາຍຂໍ້ມູນໃຫຍ່

ເຖິງວ່າຈະມີຜົນປະໂຫຍດຂອງມັນ, Big Data ຍັງສະເຫນີສິ່ງທ້າທາຍ, ໂດຍສະເພາະໃນແງ່ຂອງ ຄວາມປອດໄພ ແລະຂອງ ການປົກປ້ອງຊີວິດສ່ວນຕົວ. ການຄຸ້ມຄອງການຂະຫຍາຍຕົວຂອງຂໍ້ມູນໃນຂະນະທີ່ເຄົາລົບກົດລະບຽບແລະສິດທິສ່ວນບຸກຄົນບໍ່ແມ່ນວຽກທີ່ງ່າຍ. ນອກຈາກນັ້ນ, ມີຄວາມຕ້ອງການຢ່າງຕໍ່ເນື່ອງສໍາລັບຜູ້ຊ່ຽວຊານທີ່ສາມາດຄຸ້ມຄອງແລະວິເຄາະຂໍ້ມູນນີ້ຢ່າງມີປະສິດທິພາບ.

ໂລກຂອງຂໍ້ມູນໃຫຍ່ແມ່ນກວ້າງຂວາງແລະພັດທະນາຢ່າງຕໍ່ເນື່ອງ. ດ້ວຍຄວາມກ້າວຫນ້າຂອງເທກໂນໂລຍີແລະວິທີການວິເຄາະ, ຄວາມສາມາດໃນການນໍາໃຊ້ຂໍ້ມູນເຫຼົ່ານີ້ຈະເພີ່ມຂຶ້ນເທົ່ານັ້ນ. ອົງການຈັດຕັ້ງທີ່ນໍາໃຊ້ທ່າແຮງຂອງ Big Data ຈະມີຄວາມໄດ້ປຽບໃນການແຂ່ງຂັນຢ່າງຫຼວງຫຼາຍ, ກ້າວໄປສູ່ຍຸກທີ່ຂໍ້ມູນມີຄຸນຄ່າຫຼາຍກ່ວາເກົ່າ.

ແນວຄວາມຄິດພື້ນຖານ ແລະແນວຄວາມຄິດຫຼັກ

ມື້ນີ້ພວກເຮົາມີລະດັບຂອງເຕັກໂນໂລຊີແລະເຄື່ອງມືທີ່ເຮັດໃຫ້ການປະມວນຜົນຂອງຂໍ້ມູນຂະຫນາດໃຫຍ່, ຫຼື “ຂໍ້ມູນໃຫຍ່”. ຄວາມເຂົ້າໃຈກ່ຽວກັບເຕັກໂນໂລຢີເຫຼົ່ານີ້ແມ່ນພື້ນຖານສໍາລັບທຸກຄົນທີ່ຕ້ອງການເຮັດວຽກກັບຊຸດຂໍ້ມູນຂະຫນາດໃຫຍ່ຫຼືມີສ່ວນຮ່ວມໃນໂຄງການການຫັນປ່ຽນດິຈິຕອນ.

ໂຄງສ້າງພື້ນຖານການເກັບຮັກສາ

ພື້ນຖານຂອງຍຸດທະສາດການປຸງແຕ່ງຂໍ້ມູນໃຫຍ່ໃດໆແມ່ນ ໂຄງສ້າງພື້ນຖານການເກັບຮັກສາ ແຂງແຮງ ແລະສາມາດຂະຫຍາຍໄດ້. ນີ້ແມ່ນບາງທາງເລືອກທີ່ມີຢູ່ໃນຕະຫຼາດ:

- Hadoop Distributed File System (HDFS) : ລະບົບໄຟລ໌ແຈກຢາຍທີ່ອະນຸຍາດໃຫ້ເກັບຮັກສາຂໍ້ມູນຈໍານວນຫລາຍ.

- Amazon S3 : ບໍລິການເກັບຮັກສາວັດຖຸທີ່ສະເຫນີໂດຍ ບໍລິການເວັບ Amazon.

- Google Cloud Storage : ການແກ້ໄຂການເກັບຮັກສາທີ່ສາມາດຂະຫຍາຍໄດ້ແລະທົນທານທີ່ສະເຫນີໂດຍ Google Cloud.

- Microsoft Azure Blob Storage : ບໍລິການເກັບຮັກສາວັດຖຸຄລາວໃຫ້ໂດຍ Microsoft Azure.

ລະບົບການຈັດການຖານຂໍ້ມູນທີ່ແຈກຢາຍ

ເພື່ອຈັດການຂໍ້ມູນຈໍານວນຫຼວງຫຼາຍ, ລະບົບການຄຸ້ມຄອງຖານຂໍ້ມູນແບບດັ້ງເດີມແມ່ນບໍ່ພຽງພໍ. ຖານຂໍ້ມູນທີ່ແຈກຢາຍຕໍ່ໄປນີ້ເຮັດໃຫ້ການປະມວນຜົນ ແລະການວິເຄາະຂໍ້ມູນຂະໜາດໃຫຍ່:

- Apache Cassandra : ຖືກອອກແບບເພື່ອຈັດການຂໍ້ມູນຈໍານວນຫຼວງຫຼາຍທີ່ແຈກຢາຍໃນທົ່ວເຄື່ອງແມ່ຂ່າຍຈໍານວນຫຼາຍ.

- MongoDB : ຖານຂໍ້ມູນ NoSQL ອະນຸຍາດໃຫ້ຈັດການຂໍ້ມູນຂະໜາດໃຫຍ່ໄດ້ຢ່າງຄ່ອງຕົວ.

- ຕຽງນອນ : ສະຫນອງປະສິດທິພາບສູງສໍາລັບຄໍາຮ້ອງສະຫມັກການໂຕ້ຕອບທີ່ມີປະລິມານຂະຫນາດໃຫຍ່ຂອງຂໍ້ມູນ.

ກອບການປະມວນຜົນຂໍ້ມູນ

ເມື່ອເກັບຮັກສາ, ຂໍ້ມູນຂະຫນາດໃຫຍ່ຕ້ອງການເຄື່ອງມືພິເສດເພື່ອດໍາເນີນການແລະວິເຄາະປະສິດທິຜົນ. ໂຄງຮ່າງການຕໍ່ໄປນີ້ແມ່ນມີຄວາມຈໍາເປັນໃນລະບົບນິເວດນີ້:

- Apache Hadoop : ສະພາບແວດລ້ອມທີ່ອະນຸຍາດໃຫ້ມີການແຈກຢາຍຂໍ້ມູນຂະຫນາດໃຫຍ່ໃນທົ່ວກຸ່ມເຊີບເວີ.

- Apache Spark : ເຄື່ອງຈັກປະມວນຜົນຂໍ້ມູນໄວສຳລັບຂໍ້ມູນໃຫຍ່ທີ່ຮອງຮັບຫຼາຍພາສາການຂຽນໂປຣແກຣມ.

- Apache Flink : ໂຄງຮ່າງການສຸມໃສ່ການປະມວນຜົນຂໍ້ມູນໃນເວລາຈິງ ແລະຢ່າງຕໍ່ເນື່ອງ.

ເຄື່ອງມືການວິເຄາະຂໍ້ມູນ

ມັນບໍ່ພຽງພໍທີ່ຈະເກັບຮັກສາແລະປະມວນຜົນຂໍ້ມູນ; ມັນຍັງມີຄວາມສໍາຄັນທີ່ຈະສາມາດວິເຄາະພວກມັນເພື່ອສະກັດຂໍ້ມູນທີ່ເປັນປະໂຫຍດ. ນີ້ແມ່ນເຄື່ອງມືການວິເຄາະຂໍ້ມູນບາງຢ່າງທີ່ເຮັດໃຫ້ວຽກງານນີ້ງ່າຍຂຶ້ນ:

- Apache Hive : ເຄື່ອງມືທີ່ອະນຸຍາດໃຫ້ສອບຖາມແລະຈັດການຂໍ້ມູນໃນ Hadoop, ໂດຍໃຊ້ພາສາທີ່ໃກ້ຊິດກັບ SQL.

- ການແຕ້ມຮູບ : ຊອບແວທີ່ຊ່ວຍໃຫ້ຜູ້ໃຊ້ສ້າງຮູບພາບຂໍ້ມູນແລະ dashboards ແບບໂຕ້ຕອບ.

- ພະລັງງານ BI ຂອງ Microsoft: ເຄື່ອງມືທາງທຸລະກິດສໍາລັບການວິເຄາະຂໍ້ມູນແລະການແບ່ງປັນ.

ບໍລິການຄອມພິວເຕີຄລາວ ແລະຂໍ້ມູນໃຫຍ່

THE ຄອມພິວເຕີ້ຟັງ ໄດ້ປະຕິວັດວິທີການທຸລະກິດເຂົ້າຫາການປະມວນຜົນຂໍ້ມູນໃຫຍ່. ການບໍລິການຫຼາຍຢ່າງມີໃຫ້ເພື່ອອັດຕະໂນມັດ ແລະ ເຮັດໃຫ້ການດໍາເນີນງານງ່າຍຂຶ້ນ:

- Google BigQuery : ຄັງເກັບຂໍ້ມູນວິສາຫະກິດທີ່ບໍ່ມີເຊີບເວີທີ່ຖືກອອກແບບມາສໍາລັບການວິເຄາະຂໍ້ມູນໃນລະດັບ.

- ບໍລິການຂໍ້ມູນໃຫຍ່ຂອງ AWS : ບໍລິການຕ່າງໆໃຫ້ໂດຍ Amazon ເພື່ອປະມວນຜົນຂໍ້ມູນໃຫຍ່, ເຊັ່ນ Elastic MapReduce (EMR).

- Azure HDInsight : ການບໍລິການສະຫນອງໃຫ້ໂດຍ Microsoft ທີ່ສະຫນອງການແກ້ໄຂ Hadoop ໃນຟັງໄດ້.

Mastering ເຕັກໂນໂລຊີແລະເຄື່ອງມືເຫຼົ່ານີ້ແມ່ນຂະບວນການທີ່ຊັບຊ້ອນ, ຮຽກຮ້ອງໃຫ້ມີຄວາມເຂົ້າໃຈເລິກຂອງຂໍ້ມູນຂະຫນາດໃຫຍ່ແລະສະຖາປັດຕະທີ່ສະຫນັບສະຫນູນປະລິມານຂະຫນາດໃຫຍ່ເຫຼົ່ານີ້. ຢ່າງໃດກໍຕາມ, ສໍາລັບຜູ້ຊ່ຽວຊານໃນພາກສະຫນາມຫຼືຜູ້ທີ່ປາດຖະຫນາຢາກກາຍເປັນຫນຶ່ງ, mastering ລະດັບຂອງເຄື່ອງມືນີ້ແມ່ນເປັນສິ່ງຈໍາເປັນເພື່ອຫັນປ່ຽນ terabytes ຂອງຂໍ້ມູນດິບເຂົ້າໄປໃນຄວາມເຂົ້າໃຈທີ່ມີຄຸນຄ່າ.

ໃນສັ້ນ, ໄດ້ ຂໍ້ມູນໃຫຍ່ ຫັນປ່ຽນພູມສັນຖານຂອງທຸລະກິດ ແລະສັງຄົມໂດຍການສະໜອງຄວາມເປັນໄປໄດ້ທີ່ບໍ່ຄາດຄິດໃນເມື່ອກ່ອນສຳລັບການປະມວນຜົນ ແລະການວິເຄາະປະລິມານເລກກຳລັງຂອງຂໍ້ມູນ. ຢ່າງໃດກໍ່ຕາມ, ມັນເປັນສິ່ງສໍາຄັນທີ່ຈະນໍາທາງຢ່າງລະມັດລະວັງເພື່ອຂຸດຄົ້ນທ່າແຮງຂອງມັນໃນຂະນະທີ່ຮັກສາຄຸນຄ່າດ້ານຈັນຍາບັນແລະຄວາມເປັນສ່ວນຕົວຂອງບຸກຄົນ.

ເຂົ້າໃຈ ແອັບ ແລະ ສິ່ງທ້າທາຍ ຂອງ ຂໍ້ມູນໃຫຍ່ ເປັນວິທີການທີ່ຈໍາເປັນສໍາລັບອົງການຈັດຕັ້ງໃດຫນຶ່ງທີ່ຕ້ອງການທີ່ຈະຍັງຄົງມີການແຂ່ງຂັນແລະມີຈັນຍາບັນໃນໂລກດິຈິຕອນທີ່ມີການປ່ຽນແປງຢ່າງຕໍ່ເນື່ອງນີ້.