https://www.youtube.com/watch?v=ShLittT7RTE

AIによる人間の知能のシミュレーション?

人間の知能を機械でシミュレートする能力は、科学者にとっても一般の人々にとっても、常に特別な魅力となってきました。人間のように思考、推論、理解できる機械というアイデアがまだ SF のように思えるかもしれませんが、人工知能 (AI) の進歩は、私たちがこれまで以上にこの現実に近づいていることを証明しています。この人間の知性の印象的なシミュレーションの側面を一緒に分析してみましょう。

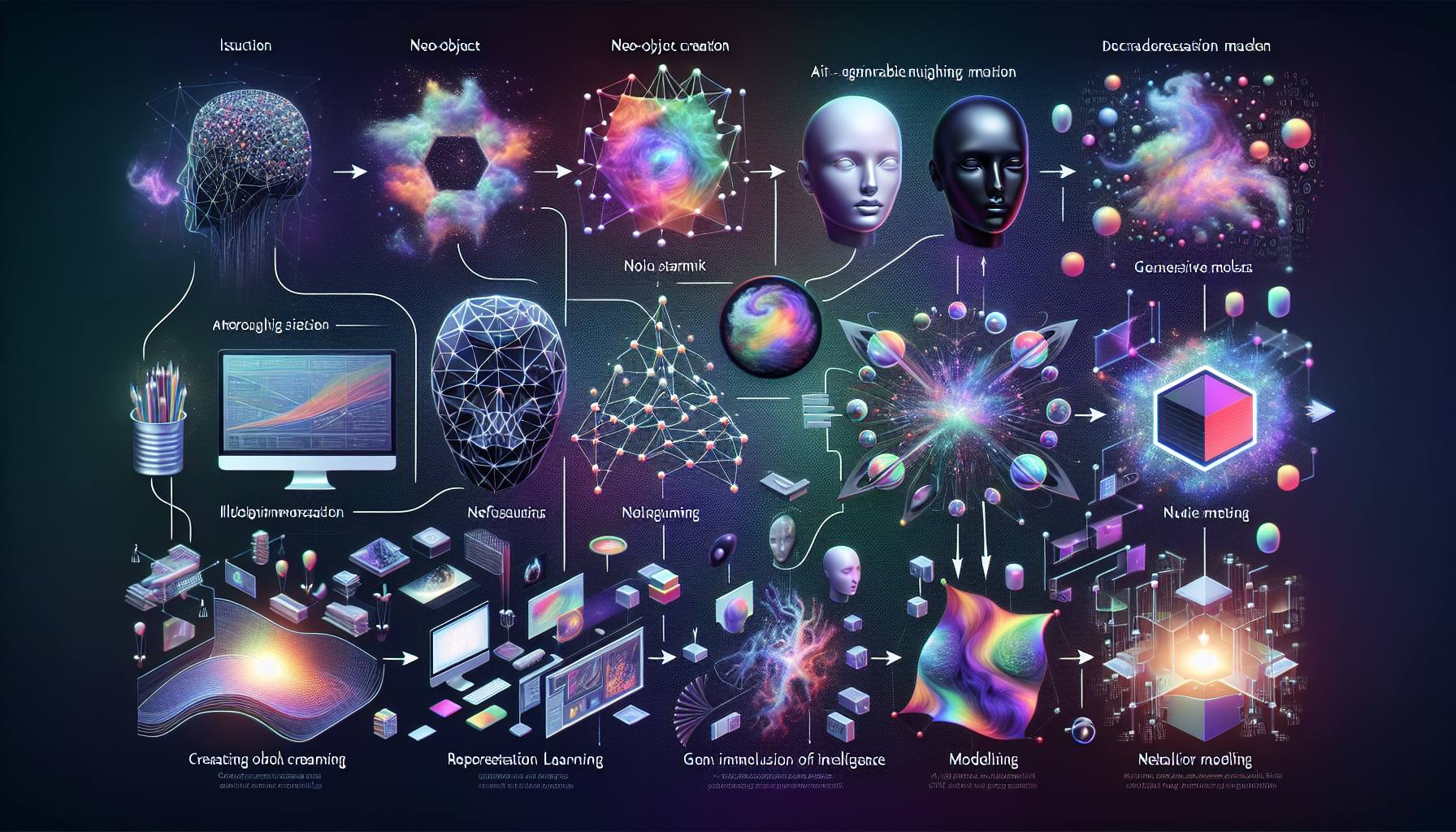

人間知能シミュレーションとは何ですか?

機械による人間の知能のシミュレーションは、強力な AI または一般的な AI と呼ばれることが多く、人間が実行する場合には知能が必要となるタスクをコンピューター プログラムが実行できる能力を指します。これには、言語の理解、パターンとイメージの認識、合理的な意思決定、さらには創造性が含まれます。

主要な AI テクノロジー

人間の知能をシミュレートするために、いくつかのテクノロジーとアプローチが実装されています。

– 機械学習 : 経験とデータを通じてマシンを改善できるアルゴリズム。

– ディープラーニング : 人工ニューラル ネットワークを使用して人間の脳の機能を模倣する機械学習のサブセット。

– 自然言語処理 (TLP) : 機械が人間の言語を理解して生成できるようにする技術。

これらのテクノロジーは多くの場合、巨大なデータセットとかなりのコンピューティング能力によってサポートされており、人間の心と同じような方法で複雑なパターンや「推論」を認識することができます。

人間の知能シミュレーションの雄弁な例

大手テクノロジー企業のいくつかのプロジェクトと製品は、人間の知能のシミュレーションにおいて私たちがどこまで到達したかを示しています。

– IBM 彼のシステムでは ワトソン、Jeopardyで優勝したことで知られています!人間の競争相手に対して。

– Googleディープマインド 作成した アルファ碁、その複雑さで有名な囲碁の世界チャンピオンを破ったプログラムです。

– OpenAI 発展した GPT-3、驚くほど一貫性があり、文脈に関連したテキストを生成できる言語モデルです。

人間の知能をシミュレートする利点と影響

人間の知能のシミュレーションには、私たちの社会を変える可能性のある多くの利点があります。

– 複雑なタスクの自動化

– 医療や金融などの重要な分野での意思決定支援

– テクノロジーとのより自然で直感的なインタラクション

– アートやデザインなどの分野で AI によって強化されるイノベーションと創造性

ただし、この進歩には、AI システムのセキュリティ、機械学習における潜在的なバイアス、雇用や社会への影響など、倫理的な問題や課題も伴います。

人間の知能シミュレーションの未来

人間の知能をシミュレートする長期的な可能性は、疑問を引き起こすと同時に多くの熱意を呼び起こします。パーソナルロボット、個別化医療、さらにはインテリジェント輸送システムなど、さまざまな分野で大きな進歩が期待できます。 AI との緊密な連携は、私たちの働き方、余暇活動、周囲の世界との関わり方を再考することにつながる可能性があります。

自律性のベールの背後にある技術的限界

AI の完全な自律性という幻想

人間の監督なしで動作できる完全自律型の機械やシステムのアイデアは、多くのプロジェクトを魅了し、推進しています。ただし、技術的な現実はさらに複雑であることが判明しました。現在、「自律型」というラベルで販売されているシステムには、安全で効率的な動作を保証するために多くの条件と保護手段が必要です。

人間の監督に依存していることは否定できません

私たちは自律走行車や自ら意思決定できる家庭用ロボットについてよく話しますが、人間による監視は依然として時代遅れには程遠いです。のようなブランド あなたはここにいます その優れた例が半自動運転車です。その優れた性能にもかかわらず、道路上では予期せぬ困難が発生する可能性があるため、ドライバーは常に注意を払う必要があります。

1. 継続的なアップデートとメンテナンス

2. 事故防止のための監督

3. 障害または予期せぬ状況が発生した場合の手動介入

機械の視覚認識、状況理解、予期せぬ出来事への適応には限界があるため、人間による監視が不可欠であることが浮き彫りになっています。

IBM、 グーグル、および AI 分野の他のリーダーは、これらの根本的な限界に直面しながら、これらのテクノロジーの限界を押し上げるために常に努力しています。

さて、以上のことはすべて終わりました。その理由を見てみましょう。AI は実際には知性の幻想にすぎません…

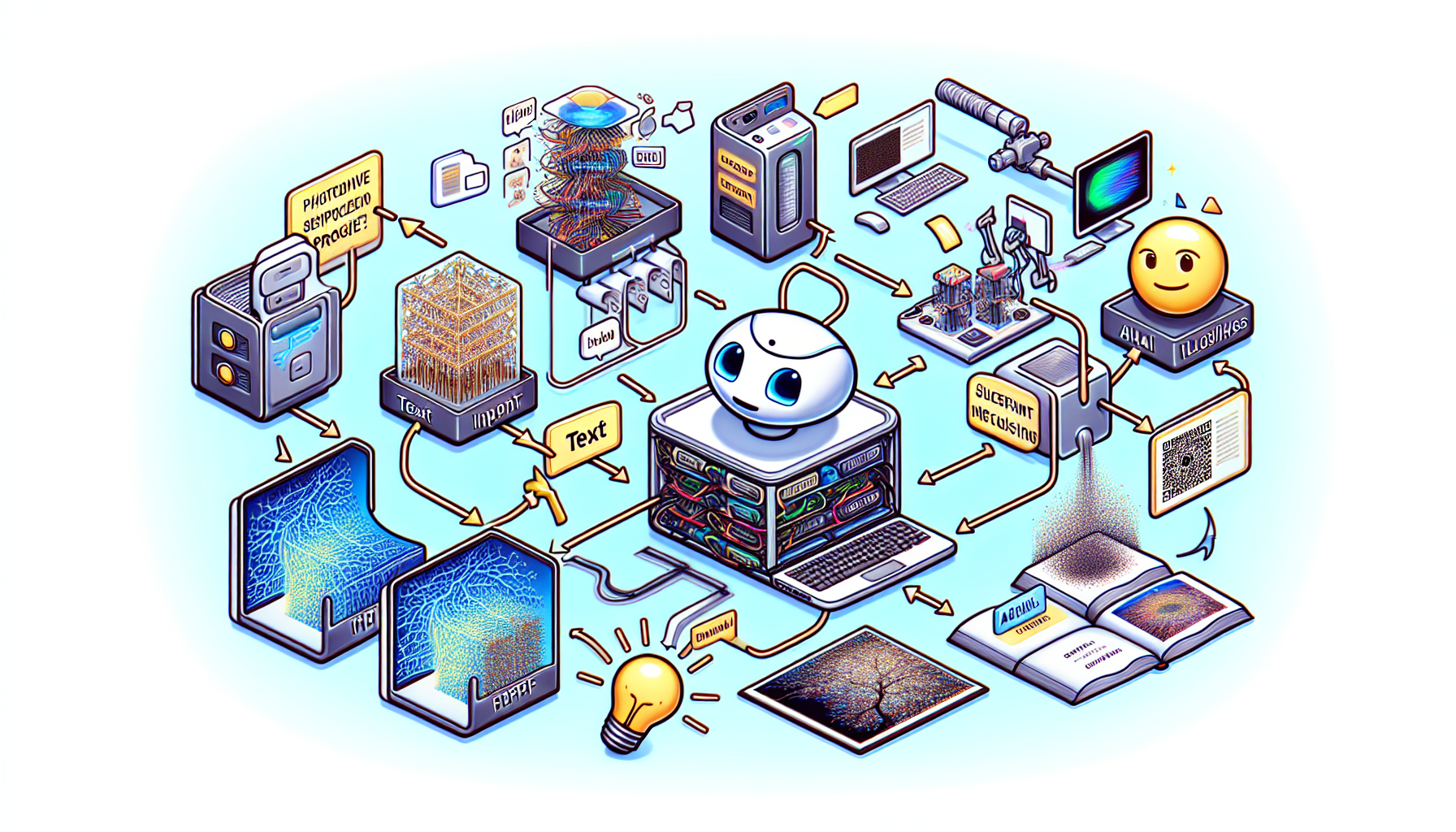

ChatGPT インタラクションにおける理解と認識の錯覚

ChatGPT のような人工知能システムと対話すると、自分と同じような感情や経験を理解し、共有する存在と通信しているように感じることがあります。これは、驚くべき流動性と一貫性の応答を生成する高度なプラットフォームではさらに顕著です。

しかし、私たちは立ち止まって、これらのやり取りの背後にある現実を識別する必要があります。それは理解と意識の幻想であり、人間のような真の感情的または認知的知性ではありません。

理解しているという幻想

ChatGPT のようなモデルは、膨大な量のテキスト データでトレーニングされ、関連性があり情報に基づいた応答を生成できます。ただし、この関連性は複雑なアルゴリズムの結果であり、世界や会話の特定のコンテキストを実際に理解したものではありません。

– キーワード認識能力

– 予測モデルを使用した一貫した文章の組み立て

– 深い文脈理解の欠如

意識の錯覚

AI ベースのチャットボットと対話するとき、高度なパーソナライズと応答の適応により、チャットボットには意識があると思われるかもしれません。しかし、意識には世界の主観的な経験、つまり自律的な感情や思考を経験する能力が含まれており、これは現在の AI の能力を超えています。

– 本当の感情を伴わない共感的な反応

– アイデンティティを意識しないパーソナライゼーションの模倣

– 実際の好みや願望を持たない興味のシミュレーション